سفر به دنیای شبکه های عصبی با سامان: پس انتشار خطا (قسمت سوم)

7دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

حل معمای یادگیری بعد از اینکه سامان فهمید شبکه های عصبی چگونه اطلاعات را از لایههای ورودی تا لایههای خروجی عبور میدهند، هنوز یک سوال بزرگ در ذهنش باقی مانده بود: « چطور این شبکهها میتوانند هر بار بهتر شوند؟» تا الان میدانست که شبکهها به نوعی مانند مغز انسان یاد میگیرند، اما هنوز نمیدانست دقیقاً چطور این یادگیری اتفاق میافتد.

شبها که روی تختش دراز میکشید، صدای آرامی از هوش مصنوعی در گوشش شنیده میشد: «سامان، آمادهای راز یادگیری شبکه های عصبی را بفهمی؟ به چیزی که به آن پسانتشار خطا میگویند.»

قسمت قبل: سفر به دنیای شبکه های عصبی با سامان: سفری به عمق شبکههای عصبی (قسمت دوم)

سرفصل های مقاله

پس انتشار خطا در شبکه های عصبی چیست؟

سامان پرسید: «این پسانتشار خطا چیه؟» هوش مصنوعی با لحنی دوستانه گفت: «فرض کن وقتی میخواهی یک عکس از گربه را به شبکه بدهی، شبکه اشتباه میکند و میگوید که این عکس متعلق به یک سگ است. خب، شبکه باید از این اشتباه چیزی یاد بگیرد، درسته؟ پس نیاز دارد که خطای خودش را تشخیص بدهد و آن را اصلاح کند. به این فرآیند اصلاح خطا میگوییم پسانتشار خطا.»

چطور خطاها محاسبه میشوند؟

سامان همچنان مشتاق بود بیشتر بداند: «خب، چطور این خطاها محاسبه میشوند؟» صدای هوش مصنوعی ادامه داد: « شبکه برای هر تصمیمی که میگیرد، یک خروجی پیشبینیشده دارد. مثلاً در مثال تصویر گربه، خروجی درست این است که “این یک گربه است”. اگر شبکه بگوید “این یک سگ است”، خطا رخ داده. این خطا در واقع تفاوت بین خروجی پیشبینیشده و خروجی واقعی است. در مرحله بعد، خطا از لایه خروجی به عقب برمیگردد و شبکه آن را به تک تک نورونهای پنهان ارسال میکند تا وزنهای اشتباهشان را اصلاح کنند.»

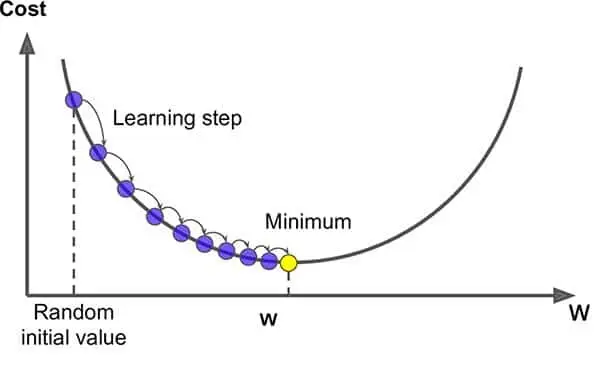

الگوریتم گرادیان نزولی: دوست جدید سامان با دقت گوش میداد. هوش مصنوعی ادامه داد: «این کار توسط یک الگوریتم به نام گرادیان نزولی انجام میشود. فرض کن داری از یک تپه بالا میروی و میخواهی سریعترین راه را برای رسیدن به قله پیدا کنی. گرادیان نزولی هم همین کار را میکند؛ به شبکه کمک میکند تا وزنهای نورونها را در هر مرحله بهینه کند و سریعتر به نتیجه درست برسد.»

وزندهی نورونها : تغییرات کوچک، تفاوتهای بزرگ سامان حالا به خوبی فهمیده بود که وزندهی نورونها چقدر مهم است. هوش مصنوعی توضیح داد: « هر نورون در شبکههای عصبی یک وزن دارد که نشاندهنده اهمیت اطلاعات ورودی است. وقتی خطایی رخ میدهد، شبکه به کمک الگوریتم گرادیان نزولی این وزنها را تغییر میدهد تا در آینده تصمیمات بهتری بگیرد. مثلاً اگر نورونی باعث اشتباه شود، وزن آن کمتر میشود، و اگر نورونی تصمیم درستی بگیرد، وزن آن بیشتر میشود.»

سامان احساس کرد که حالا یکی از پیچیدهترین بخشهای شبکههای عصبی را فهمیده است. این که شبکهها چگونه با اشتباهات خود یاد میگیرند و به مرور زمان هوشمندتر میشوند، او را هیجانزده کرده بود.

مثالی برای سادهسازی

برای اینکه بهتر متوجه شود، هوش مصنوعی یک مثال سادهتر آورد: « فرض کن در حال یادگیری زبان جدیدی هستی. هر بار که اشتباه میکنی، معلم به تو یادآوری میکند که تلفظت اشتباه است و باید آن را اصلاح کنی. دفعه بعد که با همان کلمه مواجه میشوی، تلفظت را درست میکنی. شبکههای عصبی هم دقیقاً همین طور عمل میکنند؛ هر بار که اشتباهی رخ میدهد، خطا به عقب برمیگردد و نورونهای پنهان خودشان را تنظیم میکنند تا دفعه بعد بهتر عمل کنند.»

پایان قسمت سوم سامان حالا میدانست که چگونه شبکههای عصبی با استفاده از پسانتشار خطا و الگوریتم گرادیان نزولی یاد میگیرند. این فرآیند به آنها کمک میکند تا هر بار هوشمندتر و دقیقتر شوند. اما یک سوال دیگر ذهنش را مشغول کرده بود: «آیا شبکههای عصبی همیشه به همین سادگی یاد میگیرند؟» در قسمت بعد، سامان با چالشهای یادگیری شبکهها و مسائلی مثل بیشبرازش آشنا خواهد شد.

در این قسمت، فرآیند پسانتشار خطا و گرادیان نزولی به زبان ساده توضیح داده شد. در قسمت بعدی، به موضوعات چالشیتری مثل بیشبرازش (Overfitting) و راهحلهای بهینهسازی شبکههای عصبی پرداخته میشود.

گرادیان نزولی چیست؟

بعد از فهمیدم پس انتشار خطا در شبکه های عصبی، حتماً برایتان پیش آمده که وقتی درباره هوش مصنوعی و یادگیری ماشین میشنوید، با کلماتی مثل “شبکه های عصبی”، “یادگیری عمیق” یا “بهینهسازی مدل” مواجه شوید. یکی از مفاهیم بسیار مهم و پایهای در این زمینهها، الگوریتم گرادیان نزولی است.

حالا بیایید این مفهوم را به زبان ساده بررسی کنیم: فرض کنید شما در یک کوه ایستادهاید و میخواهید به پایینترین نقطه، یعنی دره، برسید. شما نمیتوانید دقیقاً ببینید دره کجاست، اما هر بار به اطراف نگاه میکنید و با بررسی شیب زمین (که نشان میدهد به کدام سمت باید حرکت کنید)، یک قدم به سمت پایین برمیدارید. هر چه بیشتر پایین بروید، به دره نزدیکتر میشوید. الگوریتم گرادیان نزولی دقیقاً همین کار را برای بهینه سازی شبکههای عصبی انجام میدهد.

چرا گرادیان نزولی مهم است؟

گرادیان نزولی یکی از اصلیترین و پرکاربردترین روشهای بهینه سازی در هوش مصنوعی و یادگیری ماشین است. شبکههای عصبی برای یادگیری و بهبود عملکرد خود، باید پارامترهای داخلی یا همان وزنها (Weights) را تنظیم کنند. این وزنها تعیین میکنند که شبکه چگونه اطلاعات ورودی را پردازش کرده و به خروجی موردنظر دست یابد. الگوریتم گرادیان نزولی به شبکه عصبی کمک میکند تا این وزنها را بهگونهای تنظیم کند که خطا (یعنی تفاوت بین پیشبینی و واقعیت) به کمترین میزان برسد.

چگونه گرادیان نزولی کار میکند؟

تصور کنید که شبکه عصبی یک معادله بسیار پیچیده است که میخواهد رابطه بین ورودی و خروجیها را پیدا کند. هدف نهایی این است که مدل بتواند برای هر ورودی، بهترین و دقیقترین پیشبینی را ارائه دهد. برای اینکه مدل به این هدف برسد، باید یاد بگیرد که خطاهایش را کاهش دهد. اینجاست که الگوریتم گرادیان نزولی وارد عمل میشود.

الگوریتم گرادیان نزولی به این صورت کار میکند:

محاسبه خطا : ابتدا مدل خطای خود را محاسبه میکند. این خطا نشان میدهد که چقدر خروجیهای پیشبینی شده با واقعیت فاصله دارند.

محاسبه گرادیان : سپس مدل محاسبه میکند که با تغییر وزنها (پارامترها) به چه شکلی میتواند خطا را کاهش دهد. این تغییرات به کمک گرادیان (شیب تابع خطا) مشخص میشوند.

بهروزرسانی وزنها: در نهایت، مدل وزنها را در جهت مخالف گرادیان تغییر میدهد تا به کمینهترین مقدار خطا برسد. این تغییرات تا جایی ادامه مییابد که مدل بهینه شود و خطا به حداقل ممکن برسد.

مثال ساده از گرادیان نزولی برای اینکه بهتر بفهمیم گرادیان نزولی چیست، بیایید یک مثال بزنیم. تصور کنید که یک دانشآموز در حال یادگیری ریاضی است. او یک مسئله سخت ریاضی را حل کرده و در پایان نمرهاش را دریافت میکند. نمره او نشاندهنده میزان خطا است. هر بار که او نمرهاش را میبیند، متوجه میشود که کجاها اشتباه کرده و سعی میکند آنها را اصلاح کند. با هر اصلاح، نمره او بهتر میشود تا اینکه در نهایت مسئله را بهدرستی حل میکند. این فرایند مثل گرادیان نزولی است: مدل هر بار با بررسی خطاهایش، وزنها را بهروزرسانی میکند تا بهترین پیشبینی را ارائه دهد.

انواع گرادیان نزولی

حالا که با مفهوم کلی گرادیان نزولی آشنا شدید، بهتر است بدانید که این الگوریتم چند نوع مختلف دارد:

گرادیان نزولی استاندارد : (Batch Gradient Descent) در این روش، مدل پس از محاسبه خطا برای تمامی دادهها، وزنها را بهروزرسانی میکند. این روش دقیق است اما ممکن است کند باشد، بهویژه اگر حجم دادهها بزرگ باشد.

گرادیان نزولی تصادفی : (Stochastic Gradient Descent) در این نوع، مدل به جای محاسبه خطا برای تمامی دادهها، وزنها را پس از هر داده بهروزرسانی میکند. این روش سریعتر است اما ممکن است کمی نوسان داشته باشد.

گرادیان نزولی مینی-بچ : (Mini-Batch Gradient Descent) این روش ترکیبی از دو روش قبلی است. مدل پس از محاسبه خطا برای چندین داده (نه همه و نه یک داده)، وزنها را بهروزرسانی میکند. این روش هم سرعت بالایی دارد و هم دقت خوبی.

گرادیان نزولی در یادگیری عمیق گرادیان نزولی در قلب یادگیری عمیق قرار دارد . شبکه های عصبی عمیق به دلیل تعداد زیاد لایهها و پارامترهایشان، به شدت به بهینهسازی نیاز دارند. الگوریتم گرادیان نزولی به این شبکهها کمک میکند تا با حجم زیادی از دادهها و تعداد زیادی وزن و پارامتر، بهطور کارآمد یاد بگیرند و به نتایج دقیقتری برسند.

چالشهای گرادیان نزولی البته هر الگوریتمی چالشهای خاص خود را دارد و گرادیان نزولی نیز از این قاعده مستثنی نیست:

گیر افتادن در مینیمم محلی : (Local Minima) یکی از مشکلات گرادیان نزولی این است که ممکن است در نقاطی گیر بیفتد که بهترین جواب نیستند. این نقاط به عنوان مینیمم محلی شناخته میشوند.

سرعت پایین در برخی مواقع : در برخی موارد، بهویژه زمانی که تابع خطا پیچیده است، گرادیان نزولی ممکن است به کندی به هدف برسد.

انتخاب نرخ یادگیری : (Learning Rate) اگر نرخ یادگیری خیلی کوچک باشد، الگوریتم به کندی یاد میگیرد و اگر خیلی بزرگ باشد، ممکن است مدل نتواند به درستی بهینهسازی کند.

نتیجهگیری

اهمیت گرادیان نزولی در هوش مصنوعی الگوریتم گرادیان نزولی یکی از مهمترین و پایهایترین ابزارهای بهینهسازی در دنیای هوش مصنوعی است. این الگوریتم به ما کمک میکند تا با تغییر وزنها و کاهش خطا، مدلهایی با دقت بالا ایجاد کنیم. گرادیان نزولی نه تنها در یادگیری ماشین بلکه در یادگیری عمیق نیز نقش کلیدی دارد و بدون آن، بسیاری از پیشرفتهای اخیر در هوش مصنوعی امکانپذیر نبود.