چطور با Flashtensors زمان بارگذاری مدلها را تا ۱۰ برابر کاهش دهیم؟

3دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

یکی از چالشهای بزرگ در استقرار مدلهای هوش مصنوعی، زمان طولانی بارگذاری یا همان cold start است. بهویژه زمانی که چند مدل بزرگ روی یک سرور یا GPU مستقر میشوند، بالا آمدن مدلها میتواند چندین دقیقه طول بکشد. اینجاست که ابزار Flashtensors وارد عمل میشود؛ پروژهای اوپنسورس که با هدف کاهش زمان بارگذاری مدلها تا ۱۰ برابر طراحی شده است.

سرفصل های مقاله

Flashtensors چیست؟

Flashtensors یک لودر و انجین اینفرنس سبک است که دادههای مدل را با سرعت بسیار بالا از SSD به GPU منتقل میکند. این ابزار برای اجرای مدلهای بزرگ در محیطهایی با منابع محدود توسعه یافته و امکان hotswap کردن مدلها در کمتر از ۲ ثانیه را فراهم میکند. به بیان ساده، Flashtensors باعث میشود مدلها تقریباً بلادرنگ بارگذاری شوند، بدون آنکه کارایی دستگاه تحت تأثیر قرار گیرد.

چگونه Flashtensors کار میکند؟

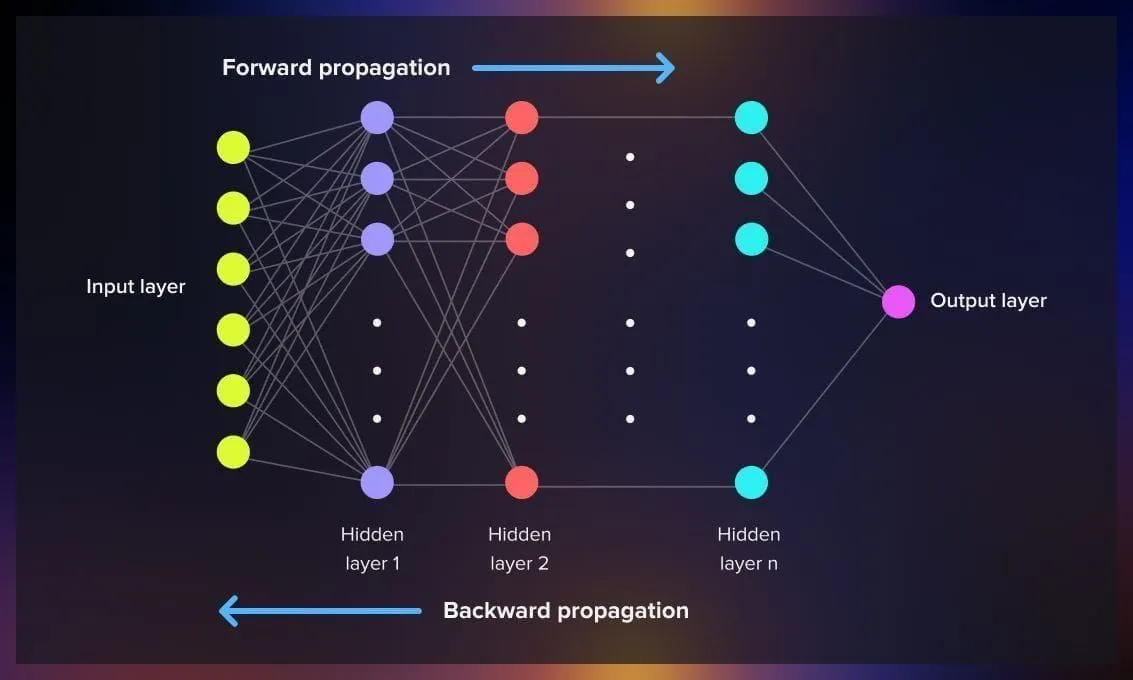

ایدهی اصلی Flashtensors بر پایهی سه بهینهسازی اصلی است:

۱. خواندن موازی از دیسک

در روشهای سنتی، دادههای مدل بهصورت ترتیبی از SSD به VRAM منتقل میشوند. اما Flashtensors با تقسیم وزنها به بخشهای کوچکتر (Chunking) و خواندن همزمان آنها با چند نخ (Threads)، سرعت انتقال را چند برابر میکند.

۲. کاهش Memcpy از PCIe

در Flashtensors دادهها مستقیماً در بافرهای GPU بارگذاری میشوند، بدون نیاز به کپیهای متوالی بین حافظهی سیستم و GPU. این کار بهطور میانگین ۴ تا ۶ برابر سرعت بارگذاری را افزایش میدهد.

۳. مدیریت حافظه و میزان استفاده

Flashtensors با مدیریت هوشمند استخر حافظه (memory pool) و تخصیص بهینهی VRAM، اجازه میدهد دهها مدل بزرگ را در یک GPU واحد میزبانی کنید.

چرا Flashtensors بهتر از لودرهای سنتی است؟

در بنچمارکهای انجام شده روی GPU های NVIDIA H100 نتایج زیر به دست آمده است:

| مدل | Flashtensors (ثانیه) | Safetensors (mmap) (ثانیه) | افزایش سرعت |

|---|---|---|---|

| Qwen/Qwen3-0.6B | 2.74 | 11.68 | ≈ 4.3× |

| Qwen/Qwen3-4B | 2.26 | 8.54 | ≈ 3.8× |

| Qwen/Qwen3-8B | 2.57 | 9.08 | ≈ 3.5× |

| Qwen/Qwen3-14B | 3.02 | 12.91 | ≈ 4.3× |

| Qwen/Qwen3-32B | 4.08 | 24.05 | ≈ 5.9× |

میانگین سرعت بارگذاری ۴ تا ۶ برابر افزایش یافته و حتی برای مدلهای ۳۲ میلیارد پارامتری، زمان راهاندازی زیر ۵ ثانیه باقی میماند.

نصب و راهاندازی

نصب این ابزار بسیار ساده است:

pip install git+https://github.com/leoheuler/flashtensors.git

سپس میتوانید با دستورات زیر سرویس daemon را راهاندازی کنید:

flash start

flash pull Qwen/Qwen3-0.6B

flash run Qwen/Qwen3-0.6B "Hello world"

این دستورات مدل را دانلود، بارگذاری و اجرا میکنند — آن هم در کمتر از ۲ ثانیه.

استفاده از SDK برای Python

برای کاربران پایتون، Flashtensors یک SDK اختصاصی دارد که با کتابخانهی vLLM سازگار است.

نمونهی ساده:

import flashtensors as ft

from vllm import SamplingParams

ft.configure(storage_path="/tmp/models", mem_pool_size=30*1024**3, gpu_memory_utilization=0.8)

ft.activate_vllm_integration()

model_id = "Qwen/Qwen3-0.6B"

llm = ft.load_model(model_id=model_id, backend="vllm", dtype="bfloat16")

prompts = ["Hello", "Future of AI"]

params = SamplingParams(temperature=0.1, top_p=0.95, max_tokens=50)

outputs = llm.generate(prompts, params)

این کد مدل را در حالت سریع بارگذاری میکند و میتواند برای ایجاد پاسخهای متنی مورد استفاده قرار گیرد.

کاربردهای اصلی Flashtensors

Flashtensors تنها برای شتاب دهی به مدلهای زبان بزرگ نیست، بلکه در دامنههای زیر نیز کاربرد دارد:

- استقرار سرویسهای Serverless AI با بارگذاری مدل در لحظه

- اجرای هوش مصنوعی شخصیسازی شده روی دستگاههای لبه (edge)

- رباتیک و پوشیدنیها که نیاز به پاسخدهی سریع دارند

- محیطهای on-prem که در آنها دسترسی به GPU محدود است

چرا Flashtensors برای توسعهدهندگان مهم است؟

در دنیایی که کارایی و زمان پاسخ عامل کلیدی در محصولات AI است، Flashtensors به توسعهدهندگان اجازه میدهد تعداد زیادی مدل را روی یک GPU واحد میزبانی کنند و بدون افزایش هزینه، تجربهی کاربر را بهبود دهند. در واقع Flashtensors مدیریت منابع را بهصورت هوشمند و کاربردی بازنویسی کرده است.

جمعبندی

Flashtensors یک پروژهی اوپنسورس تحولی در شتابدهی به لود مدلهاست. با خواندن موازی، کاهش کپی دادهها و مدیریت هوشمند حافظه، زمان بارگذاری مدلها را تا ۱۰ برابر کاهش میدهد. اگر در حال ساخت سیستم AI با چند مدل بزرگ هستید یا میخواهید تجربهی کاربران را بهبود دهید، استفاده از Flashtensors میتواند گام بلندی در کاهش تاخیر و افزایش کارایی باشد.

کلمه کلیدی: زمان بارگذاری مدلها

اسلاگ: reduce-model-loading-time-with-flashtensors

توضیحات متا: آموزش کامل کاهش زمان بارگذاری مدلهای هوش مصنوعی تا ۱۰ برابر با استفاده از Flashtensors؛ لودر سبک و بهینه برای GPU ها و محیطهای Serverless.