آشنایی با الگوریتم های یادگیری تقویتی (Reinforcement Learning)

3دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

یادگیری تقویتی (Reinforcement Learning) یکی از شاخههای یادگیری ماشین است که در آن یک عامل (Agent) تصمیمگیرندهای وجود دارد که به دنبال بهینهسازی رفتار خود در یک محیط (Environment) میباشد. این الگوریتمها از تعامل با محیط استفاده میکنند تا بهترین سیاست (Policy) را برای دستیابی به بیشترین پاداش (Reward) پیدا کنند. در این مقاله، به مفاهیم کلیدی و الگوریتم های یادگیری تقویتی پرداخته خواهد شد.

سرفصل های مقاله

۱. مفاهیم اساسی

۱.۱. عامل (Agent)

عامل، سیستمی است که تصمیم میگیرد و اقداماتی انجام میدهد تا پاداش خود را به حداکثر برساند. برای مثال، یک ربات یا برنامه کامپیوتری که در یک محیط عمل میکند.

۱.۲. محیط (Environment)

محیط نمایانگر فضایی است که عامل در آن عمل میکند. این محیط شامل وضعیتها (States)، اقدامها (Actions) و پاداشها (Rewards) است. به عبارتی، عامل با انتخاب اقداماتی در هر وضعیت به محیط واکنش نشان میدهد.

۱.۳. وضعیت (State)

وضعیت نمایانگر وضعیت فعلی محیط است. این میتواند اطلاعاتی درباره محیط، مختصات یک ربات، یا هر داده دیگری باشد که برای تصمیمگیری نیاز است.

۱.۴. پاداش (Reward)

پاداش یک عدد عددی است که به عامل داده میشود تا نشان دهد کدام اقدام چقدر خوب یا بد بوده است. هدف عامل حداکثر کردن مجموع پاداشهای دریافتی خود در طول زمان است.

۲. الگوریتمهای اصلی یادگیری تقویتی

مجموعهای از الگوریتمهای مختلف در یادگیری تقویتی وجود دارد که هر کدام روشهای خاص خود را برای یادگیری و بهبود فعالیتهای عامل دارند. در ادامه به مهمترین این الگوریتمها اشاره میشود.

۲.۱. Q-Learning

Q-Learning یکی از الگوریتمهای مشهور یادگیری تقویتی است که به روشی آفلاین کار میکند. این الگوریتم از یک جدول Q برای ذخیره پاداشهای پیشبینیشده برای هر حالت و اقدام استفاده میکند. عامل هنگام تعامل با محیط، این جدول را بهروزرسانی میکند.

۲.۲. SARSA

SARSA (State-Action-Reward-State-Action) مشابه Q-Learning است، اما برخلاف آن، سیاست فعلی عامل را در نظر میگیرد و از اقدامات واقعی که عامل در حین یادگیری انتخاب میکند، برای بروزرسانی جدول Q استفاده میکند.

۲.۳. Deep Q-Networks (DQN)

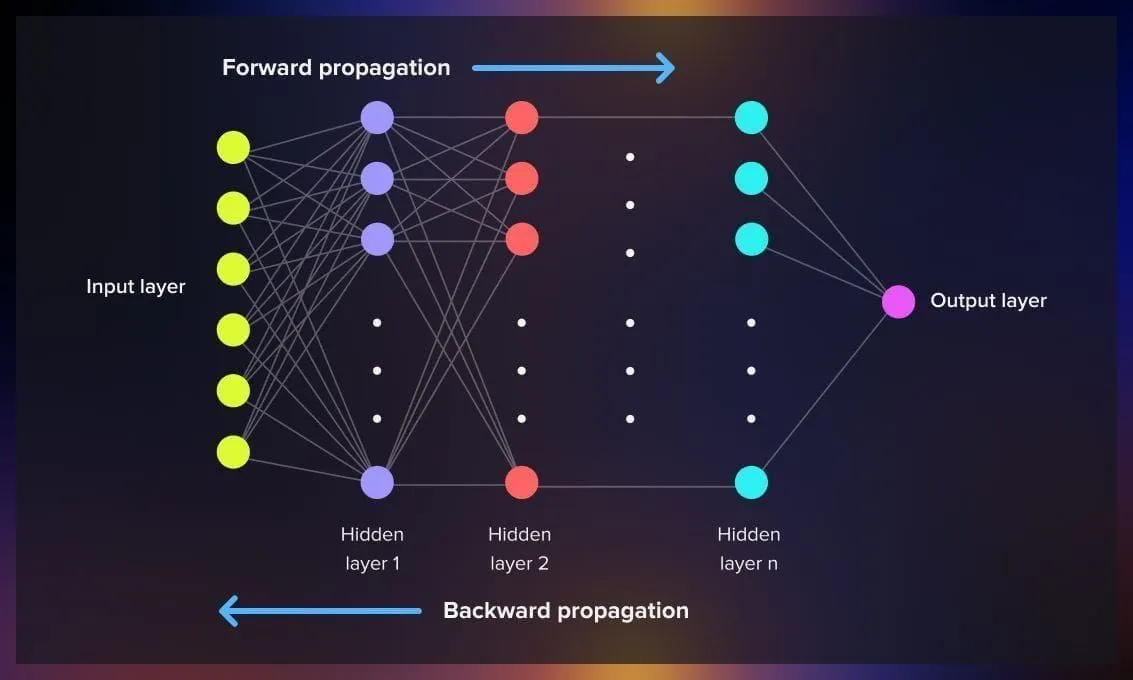

Deep Q-Networks از یادگیری عمیق برای تقویت Q-Learning استفاده میکنند. بهجای استفاده از جدول Q، از یک شبکه عصبی عمیق برای تقریب زدن تابع Q استفاده میشود، که این امکان را به عامل میدهد تا در محیطهای پیچیدهتری که دارای تعداد وضعیتهای زیاد هستند، عملکرد بهتری داشته باشد.

۲.۴. Policy Gradient Methods

این روشها بهجای یادگیری تابع Q، مستقیماً سیاست عامل را یاد میگیرند. الگوریتمهای policy gradient مانند REINFORCE به عامل این امکان را میدهند که بهطور مداوم سیاست خود را بر اساس پاداشهای دریافتی بهروزرسانی کند.

۳. چالشها و کاربردها

۳.۱. چالشها

یادگیری تقویتی چالشهای خاص خود را دارد. از جمله این چالشها میتوان به اکتشاف و بهرهبرداری (Exploration vs. Exploitation) اشاره کرد. عامل باید تصمیم بگیرد که آیا اقدام جدیدی را امتحان کند (اکتشاف) یا از اقداماتی که قبلاً پاداش دادهاند (بهرهبرداری) استفاده کند.

۳.۲. کاربردها

یادگیری تقویتی در بسیاری از زمینهها کاربرد دارد، از جمله:

- رباتیک: آموزش رباتها برای انجام وظایف پیچیده.

- بازیها: یادگیری بازیهایی مانند شطرنج، گو، و ویدئو گیمها.

- مدیریت منابع: بهینهسازی مصرف انرژی و منابع در سیستمهای پیچیده.

- خودرانها: بهکارگیری در اتومبیلهای خودران برای تصمیمگیری در وضعیتهای واقعی.

نتیجه گیری

یادگیری تقویتی یک حوزه پرتحول و جذاب است که بهشدت مورد توجه پژوهشگران و صنعتگران قرار دارد. با تواناییهای یادگیری پیچیده و کاربردهای گسترده، این فناوری در حال تبدیل شدن به یکی از ابزارهای کلیدی در دنیای هوش مصنوعی است. با ادامه تحقیقات و توسعه، انتظار میرود که الگوریتم های یادگیری تقویتی در آینده بهبود یابند و به کاربردهای جدید و جذابتری دست یابند.