Embedding در هوش مصنوعی چیست؟ رمز درک معنی کلمات توسط ماشینها

4دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

در دنیای هوش مصنوعی، یکی از شگفتانگیزترین تواناییها این است که ماشینها میتوانند معنای کلمات، تصاویر یا صداها را درک کنند. اما سؤال اصلی این است: چگونه یک مدل عددی میفهمد «سیب» یعنی یک میوه و نه یک وسیله نقلیه؟ پاسخ در مفهومی به نام Embedding نهفته است. این فناوری پایهای، زیربنای تمام مدلهای زبانی بزرگ مانند GPT، سیستمهای توصیهگر مثل نتفلیکس و حتی موتورهای جستوجوی هوشمند است.

سرفصل های مقاله

- Embedding چیست؟

- از کلمه تا معنا در دنیای عددی

- Embedding در مدلهای زبانی بزرگ

- کاربردهای Embedding در هوش مصنوعی

- ۱. موتورهای جستوجو

- ۲. سیستمهای توصیهگر (Recommender Systems)

- ۳. مدلهای تصویری

- ۴. تشخیص احساسات و معنا

- ساخت Embedding در عمل

- چرا Embedding انقلابی است؟

- آینده Embedding؛ از زبان تا چندوجهی بودن

- جمعبندی

Embedding چیست؟

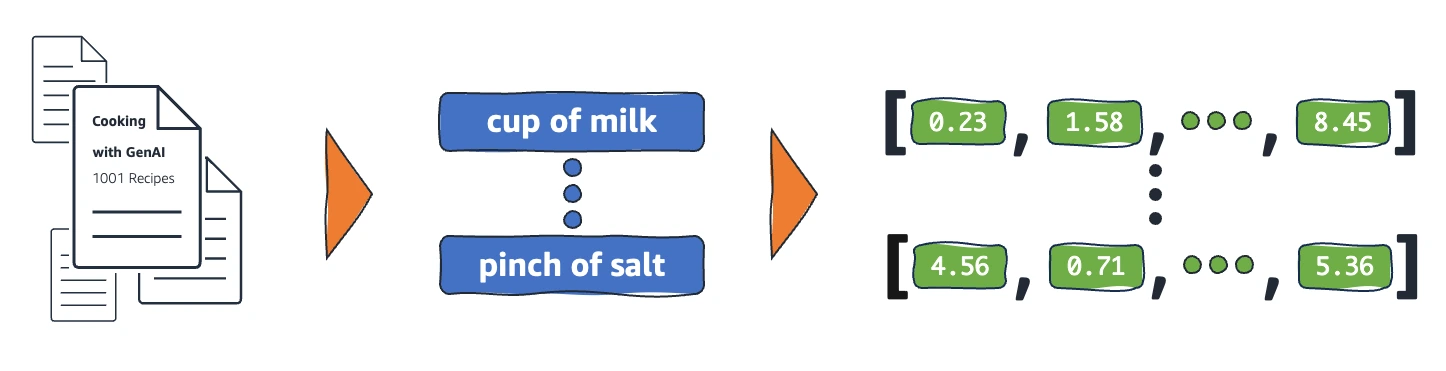

Embedding به زبان ساده یعنی تبدیل مفاهیم به عدد — اما نه هر عددی. در این فرایند، کلمات، تصاویر یا دادهها به بردارهایی با چند صد یا چند هزار بُعد تبدیل میشوند. هر بُعد، نمایانگر بخشی از ویژگی یا معنی آن مفهوم است. به عنوان مثال، کلمهی «سیب» به برداری تبدیل میشود که در فضای برداری نزدیک به «میوه» است و دور از «ماشین».

به این ترتیب، مدل یاد میگیرد شباهت مفهومی را درک کند، نه فقط شباهت نوشتاری. یعنی اگر جملهای بگوییم مثل «سیب قرمز خوشمزه است»، مدل میفهمد که «موز زرد خوشمزه است» معنای مشابهی دارد، چون بردارهای «سیب» و «موز» در فضای عددی به هم نزدیکاند.

از کلمه تا معنا در دنیای عددی

فرایند Embedding در واقع یک نوع «ترجمه» است — ترجمهی دنیای زبانی و تصویری ما به دنیای ریاضی ماشینها.

در مدلهای زبانی مثل GPT، هر توکن (کلمه یا بخشی از کلمه) به یک بردار اختصاص داده میشود. این بردارها در فرایند آموزش مدل، با تحلیل میلیاردها جمله تنظیم میشوند تا الگوهای معنایی دقیقتری را بازتاب دهند.

🔹 بهطور مثال:

- بردار «سیب» نزدیک به «میوه» و «خوراکی» است.

- اما از «ماشین» یا «آسمان» فاصله دارد.

این ساختار فاصلهای باعث میشود مدل نهتنها کلمات را بخواند، بلکه روابط میان مفاهیم را بفهمد.

Embedding در مدلهای زبانی بزرگ

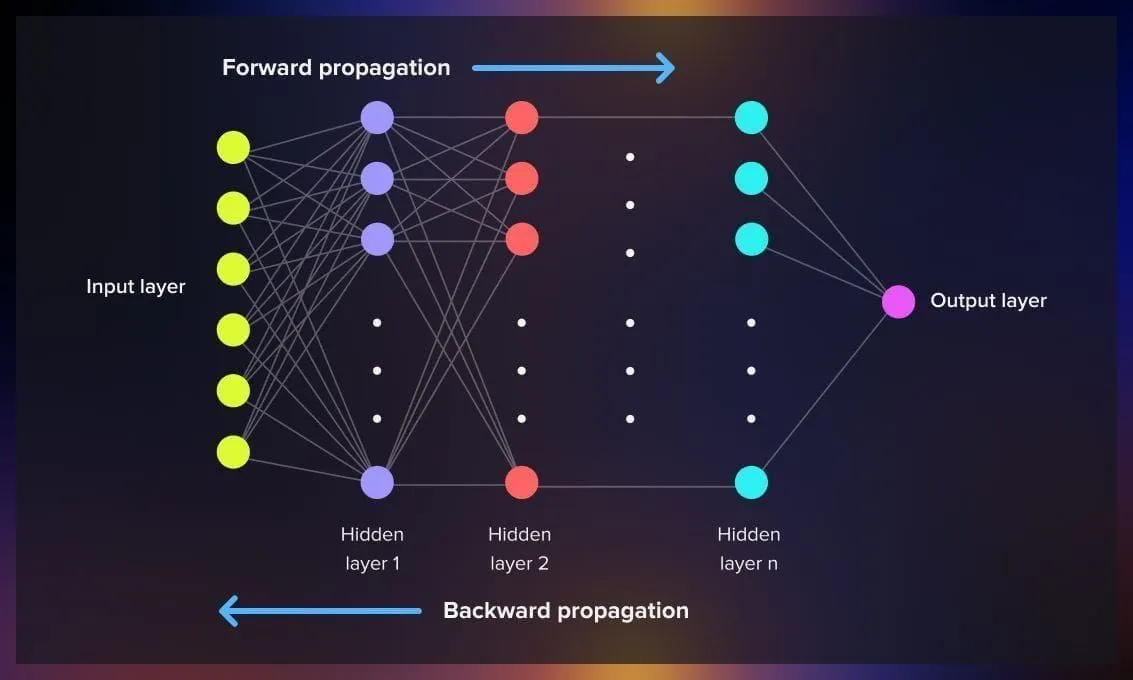

در قلب مدلهای زبانی مانند GPT، Claude و Gemini لایهای به نام Embedding Layer وجود دارد. این لایه مسئول نگاشت ورودیهای متنی به فضای برداری است. سپس لایههای بعدی (مانند Transformer Blocks) از این بردارها برای پیشبینی کلمه بعدی یا تولید پاسخ استفاده میکنند.

در واقع، بدون Embedding، هیچ مدلی قادر به «فهمیدن» متن نیست. مدل فقط دنبالهای از عددهای بیمعنی میدید. اما حالا با وجود این فناوری، مدل میتواند شباهت معنایی، احساسات و حتی طنز را هم تا حدی درک کند.

کاربردهای Embedding در هوش مصنوعی

Embedding فقط برای مدلهای زبانی نیست؛ بلکه تقریباً در تمام حوزههای هوش مصنوعی حضور دارد:

۱. موتورهای جستوجو

در سیستمهایی مثل گوگل یا ChatGPT، زمانی که عبارتی را جستوجو میکنی، Embedding به موتور کمک میکند تا سؤالات مشابه از نظر معنا را پیدا کند، نه فقط از نظر کلمات. برای مثال، اگر بنویسی «چطور سریعتر یاد بگیرم؟»، سیستم نتایجی مثل «روشهای بهبود تمرکز» را هم تشخیص میدهد.

۲. سیستمهای توصیهگر (Recommender Systems)

در پلتفرمهایی مثل نتفلیکس، اسپاتیفای یا یوتیوب، Embedding برای تحلیل سلیقه کاربران به کار میرود.

هر فیلم، آهنگ یا کاربر به یک بردار تبدیل میشود و نزدیک بودن این بردارها یعنی تشابه در سلیقه. به همین دلیل، اگر فیلم علمیتخیلی تماشا کرده باشی، نتفلیکس فیلمهای مشابه را پیشنهاد میدهد — چون در فضای برداری به هم نزدیکاند.

۳. مدلهای تصویری

در هوش مصنوعیهای تصویری مثل CLIP یا DALL·E، Embedding نقش مترجم بین «متن» و «تصویر» را دارد. متن به بردار تبدیل میشود، تصویر هم همینطور، و مدل یاد میگیرد که مثلاً عبارت «سگ در پارک» باید به چه نوع تصویرهایی نزدیک باشد.

۴. تشخیص احساسات و معنا

در تحلیل احساسات متون (Sentiment Analysis)، Embedding کمک میکند مدل بفهمد که جملهای مثل «این فیلم عالی بود!» مثبت است، چون بردار «عالی» در نزدیکی کلمات مثبت قرار دارد.

ساخت Embedding در عمل

در پایتون و کتابخانههای مدرن یادگیری ماشین مثل TensorFlow یا PyTorch، Embedding معمولاً بهصورت یک لایه جداگانه تعریف میشود:

import torch.nn as nn

embedding_layer = nn.Embedding(num_embeddings=10000, embedding_dim=300)

در این مثال، ۱۰هزار کلمه در واژگان مدل داریم و هرکدام با برداری ۳۰۰بُعدی نمایش داده میشوند. در زمان آموزش، مدل یاد میگیرد که این بردارها را طوری تنظیم کند که معنا و ارتباط میان کلمات را بازتاب دهند.

چرا Embedding انقلابی است؟

قبل از ابداع Embedding، مدلهای زبانی از روشهایی مثل One-Hot Encoding استفاده میکردند. در آن روش هر کلمه فقط به یک عدد باینری تبدیل میشد — بدون هیچ ارتباط معنایی.

اما Embedding این محدودیت را از بین برد و به ماشین اجازه داد مفهوم را بفهمد، نه فقط متن را بخواند.

نتیجه؟

مدلهایی مثل GPT یا Gemini میتوانند گفتوگوهای طبیعی، ترجمههای دقیق و حتی داستانهای خلاقانه بنویسند، چون پایهشان بر درک معنایی واقعی بنا شده است.

آینده Embedding؛ از زبان تا چندوجهی بودن

نسل جدید Embeddingها فقط به متن محدود نیستند. حالا پژوهشها روی Multimodal Embedding متمرکز شدهاند، یعنی ترکیب متن، تصویر، صدا و دادههای حسی.

به عنوان مثال، مدلهایی مثل CLIP و Flamingo یاد گرفتهاند که متن «صدای باران» را با تصویر بارش و حتی صدای واقعی آن مرتبط کنند. این یعنی در آینده، هوش مصنوعیها نهتنها زبان بلکه تجربه چندحسی انسان را هم درک خواهند کرد.

جمعبندی

Embedding قلب درک زبانی هوش مصنوعی است. این فناوری با تبدیل مفاهیم به بردارهای عددی، امکان درک معنایی را برای ماشینها فراهم کرده است. از موتورهای جستوجو تا سیستمهای پیشنهاددهنده و مدلهای زبانی بزرگ، همه به Embedding وابستهاند.

اگر روزی ماشین بتواند احساسات، خلاقیت یا حتی شوخطبعی را بفهمد، بدون شک پایهی آن در همین فناوری نهفته است.