پس انتشار خطا؛ الگوریتمی که یادگیری عمیق را متحول کرد

2دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

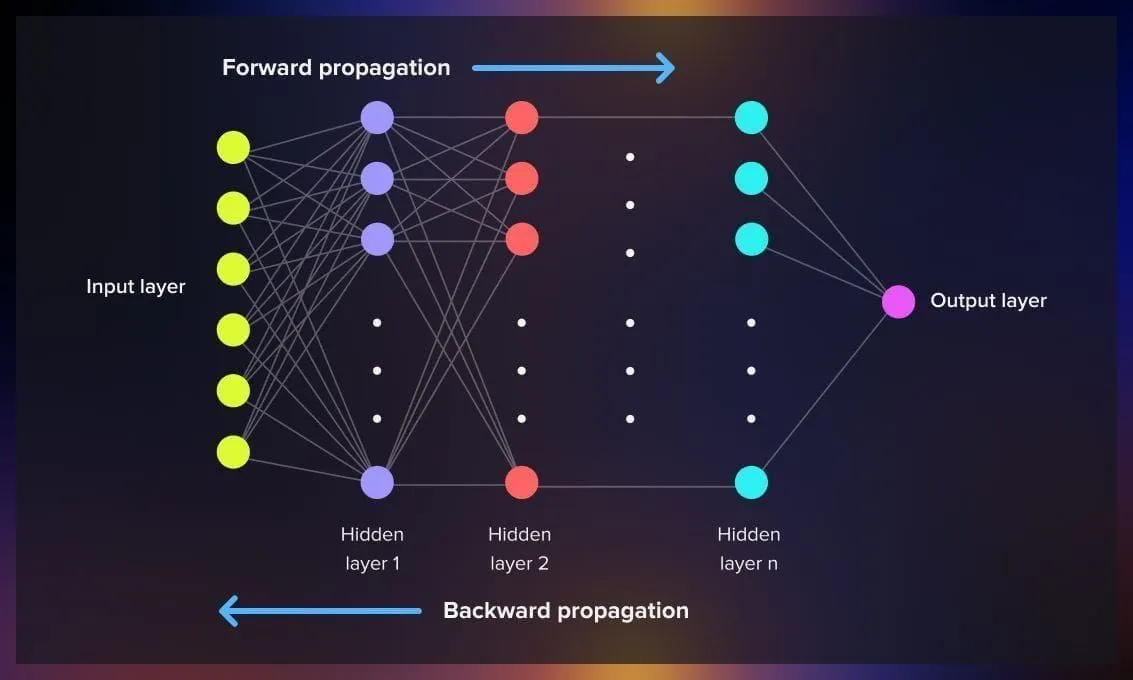

یکی از نقاط عطف مهم در تاریخچه هوش مصنوعی و یادگیری عمیق، معرفی الگوریتم پس انتشار خطا یا Backpropagation بوده است. این روش که برای بهینهسازی وزنها در شبکههای عصبی به کار میرود، باعث شد مدلهای هوش مصنوعی بتوانند وظایف پیچیدهای مانند تشخیص تصویر، پردازش زبان طبیعی و پیشبینی سریهای زمانی را با دقت بسیار بالا انجام دهند. قبل از این الگوریتم، آموزش شبکههای چندلایه با مشکل بزرگی به نام کمرنگ شدن گرادیان یا عدم پایداری یادگیری مواجه بود.

در این مقاله، به زبانی ساده و کاربردی، به بررسی مفهوم، نحوه عملکرد و اهمیت الگوریتم پسانتشار خطا میپردازیم و همچنین مزایا، محدودیتها و کاربردهای آن را مرور میکنیم.

سرفصل های مقاله

پس انتشار خطا چیست؟

پسانتشار خطا یک روش ریاضی برای محاسبه تغییرات لازم در وزنهای شبکه عصبی است تا خروجی مدل به پاسخ درست نزدیکتر شود. این الگوریتم در اصل یک پیادهسازی از قانون زنجیرهای مشتقها در حساب دیفرانسیل است که به ما اجازه میدهد از لایه خروجی به سمت لایه ورودی، خطا را به عقب منتقل کنیم.

به زبان ساده، پس از محاسبه خروجی مدل و مقایسه آن با مقدار واقعی (Label)، اختلاف یا همان خطا مشخص میشود. سپس با استفاده از مشتقگیری از تابع خطا نسبت به هر وزن، الگوریتم مشخص میکند که هر وزن چه مقدار باید تغییر کند.

مراحل اجرای الگوریتم پس انتشار خطا

۱. پیشرو (Forward Pass)

ابتدا ورودیها به شبکه داده میشوند و با گذر از لایههای مختلف، خروجی مدل محاسبه میشود.

۲. محاسبه خطا

خروجی مدل با مقدار هدف مقایسه شده و مقدار خطا با استفاده از یک تابع هزینه (مانند MSE یا Cross-Entropy) محاسبه میشود.

۳. انتشار به عقب (Backward Pass)

با استفاده از قانون زنجیرهای مشتقها، گرادیان تابع هزینه نسبت به وزنهای هر لایه محاسبه و از لایه خروجی به سمت ورودی منتقل میشود.

۴. بهروزرسانی وزنها

وزنها با استفاده از الگوریتمهای بهینهسازی مانند Gradient Descent یا Adam تغییر داده میشوند.

آموزش هوش مصنوعی (صفر تا صد کار با ابزارهای هوش مصنوعی)

اهمیت پس انتشار خطا در یادگیری عمیق

الگوریتم پسانتشار خطا ستون فقرات تمام شبکههای عصبی مدرن است. بدون این روش، آموزش مدلهایی مانند GPT، BERT، ResNet و Transformerها غیرممکن یا بسیار کند بود. این الگوریتم توانسته یادگیری چندلایه را به شکلی بهینه و پایدار انجام دهد و مسیر را برای توسعه هوش مصنوعی پیشرفته هموار کند.

مزایا

- سرعت بالا در محاسبه گرادیانها برای مدلهای بزرگ

- دقت بالا در تنظیم وزنها و کاهش خطا

- قابلیت تعمیم برای انواع شبکههای عصبی شامل CNN و RNN

محدودیتها

- مشکل Vanishing Gradient در شبکههای بسیار عمیق

- نیاز به دادههای بزرگ و پردازشگرهای قدرتمند

- حساسیت به انتخاب نرخ یادگیری (Learning Rate)

کاربردهای پس انتشار خطا

- تشخیص تصویر و بینایی ماشین

- پردازش زبان طبیعی (NLP)

- پیشبینی دادههای سری زمانی

- ترجمه ماشینی

- تشخیص گفتار و تبدیل گفتار به متن

جمع بندی

الگوریتم پسانتشار خطا یکی از بنیادیترین نوآوریها در یادگیری عمیق است که آموزش شبکههای عصبی چندلایه را ممکن ساخته است. این روش با ترکیب ریاضیات و بهینهسازی، هوش مصنوعی را از مدلهای ساده به سیستمهای پیچیده و قدرتمند امروزی رسانده است. با وجود محدودیتهایی مانند مشکل گرادیان محو، پیشرفتهای جدید در معماریها و روشهای بهینهسازی باعث شده این الگوریتم همچنان نقش کلیدی در آموزش مدلهای هوش مصنوعی ایفا کند.