راهنمای جامع فاینتیون مدلهای زبانی بزرگ با روشهای جدید

5دقیقه

آنچه در این مقاله میخوانید [پنهانسازی]

سرفصل های مقاله

- مقدمه

- فاینتیون چیست و چه زمانی لازم است؟

- تصمیمگیری برای فاینتیون

- روشهای مدرن فاینتیون

- LoRA

- QLoRA

- Spectrum

- انتخاب روش مناسب

- همترازسازی مدلها (Alignment)

- Instruction Tuning

- Direct Preference Optimization (DPO)

- آمادهسازی دادهها

- جلوگیری از بیشبرازش و فراموشی

- ابزارها و پیکربندی پیشنهادی

- مسیر یادگیری گام به گام

- جمع بندی

مقدمه

در دنیای هوش مصنوعی، فاینتیون مدلهای زبانی بزرگ (Language Model Fine-Tuning) دیگر یک کار پیچیده و پرهزینه نیست. با ظهور روشهای کارآمد مانند LoRA، QLoRA و Spectrum، حتی کاربران با کارتهای گرافیک معمولی هم میتوانند مدلهایی در حد میلیاردها پارامتر را آموزش دهند. اما پیش از شروع، باید بدانیم فاینتیون دقیقاً چه زمانی لازم است و چه روشهایی در شرایط مختلف بیشترین بازده را دارند.

فاینتیون چیست و چه زمانی لازم است؟

فاینتیون به معنی آموزش مجدد یک مدل از پیش آموزشدیده است تا آن را برای یک وظیفه خاص سازگار کنیم. در حالی که مدلهای زبانی عمومی مانند Llama یا GPT در موضوعات متنوع مهارت دارند، بسیاری از پروژهها به دقت، سبک نگارش یا دانش تخصصی بیشتری نیاز دارند. در چنین شرایطی فاینتیون بهترین گزینه است.

با این حال، همیشه نباید سراغ آن رفت. اگر با چند مثال و پرامپت خوب میتوانید نتیجه بگیرید، روش Prompt Engineering یا RAG (بازیابی و تولید) کافی است. اما اگر به مدل خاصی نیاز دارید که سبک برند، لحن خاص، یا قابلیت جدیدی را درک کند، فاینتیون ارزش دارد.

تصمیمگیری برای فاینتیون

کارشناسان گوگل و متا پنج موقعیت را برای فاینتیون پیشنهاد میکنند:

- تنظیم لحن و سبک پاسخها برای برند یا سازمان

- محافظت از دادههای خصوصی و حذف وابستگی به APIهای عمومی

- پشتیبانی از زبانهای کممنبع

- کاهش هزینه استنتاج از طریق مدلهای کوچکتر

- افزودن قابلیتهای جدید مانند خلاصهسازی خاص یا کدنویسی سبکمحور

اگر کمتر از 100 مثال دارید، تنها از پرامپت استفاده کنید. با 100 تا 1000 مثال، LoRA یا QLoRA بهترین انتخاب است. برای دادههای گستردهتر (بیش از 1000 مثال) فاینتیون کامل یا ترکیبی از چند روش نتیجه بهتری میدهد.

روشهای مدرن فاینتیون

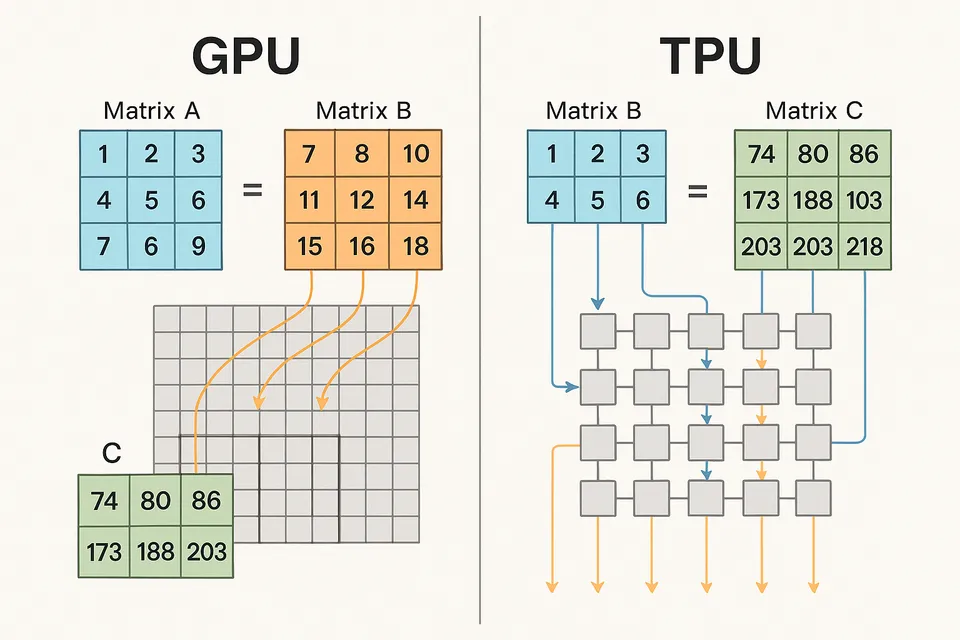

روشهای کارآمد امروزی دیگر نیاز به تغییر کامل پارامترها ندارند. این تکنیکها فقط بخش کوچکی از وزنها را تغییر میدهند و در عین حال همان دقت را ارائه میکنند.

LoRA

روش Low-Rank Adaptation با افزودن ماتریسهای کمرتبه در لایههای مدل، به جای بهروزرسانی کل وزنها، حافظه و توان محاسباتی را به شدت کاهش میدهد. در نتیجه اندازه فایل خروجی بسیار کوچک میشود و تا 10 هزار برابر سبکتر از مدل کامل است.

QLoRA

این نسخه پیشرفتهتر LoRA است که وزنها را به صورت 4 بیت ذخیره میکند و عملیات را با 16 بیت انجام میدهد. نتیجه؟ مدلهای 65 میلیارد پارامتری روی کارتهای 48 گیگابایتی یا حتی مدلهای 13 میلیاردی روی کارتهای 16 گیگابایتی اجرا میشوند.

Spectrum

نوآوری سال 2024 که بر اساس تحلیل نسبت سیگنال به نویز، فقط لایههای مهم را برای آموزش انتخاب میکند. برای مدلهای بزرگ در محیطهای توزیعشده، این روش دقت بالاتر با منابع مشابه ارائه میدهد.

انتخاب روش مناسب

- LoRA: برای سیستمهای با GPU متوسط و نیاز به صفر تأخیر در استنتاج

- QLoRA: برای سختافزارهای کمحافظه یا مدلهای بزرگتر از 30B

- Spectrum: برای پروژههای توزیعشده یا کارهای پیچیده استدلالی

همترازسازی مدلها (Alignment)

پس از فاینتیون، مرحله مهم بعدی همترازسازی است تا مدل طبق دستور کاربر پاسخ دهد. دو روش پرکاربرد وجود دارد:

Instruction Tuning

در این روش مدل با جفت دادههای سؤال و پاسخ آموزش میبیند تا به دستورها واکنش مناسب نشان دهد. حدود 1000 مثال باکیفیت میتواند مدل را به یک دستیار مفید تبدیل کند.

Direct Preference Optimization (DPO)

روش جدیدی که جایگزین RLHF شده است. در DPO، به جای استفاده از پاداش و یادگیری تقویتی، مدل به طور مستقیم از دادههای ترجیحی (پاسخ خوب در مقابل بد) یاد میگیرد. مزیت آن کاهش هزینه و سادهتر بودن پیادهسازی است.

آمادهسازی دادهها

موفقیت فاینتیون بیشتر از هر چیز به داده بستگی دارد. کیفیت پایین داده حتی با بهترین مدل هم نتیجهای ضعیف میدهد.

ویژگیهای داده خوب:

- مرتبط با حوزه کاری

- متنوع در سناریوها

- دارای برچسبگذاری دقیق

- بهروز برای حوزههای پویا

- بدون داده تکراری یا نویز

بهتر است دادهها در قالب پرسشپاسخ ساختاریافته ذخیره شوند. تقسیمبندی استاندارد 80 درصد برای آموزش و 20 درصد برای اعتبارسنجی مناسب است.

جلوگیری از بیشبرازش و فراموشی

بیشبرازش زمانی رخ میدهد که مدل فقط دادههای آموزشی را حفظ کند. نشانه آن افزایش دقت روی داده آموزش و افت عملکرد روی داده تست است.

راهحلها:

- توقف زودهنگام (Early Stopping)

- کاهش نرخ یادگیری

- افزایش دادههای متنوع

- استفاده از Dropout بین 10 تا 30 درصد

برای جلوگیری از فراموشی فاجعهآمیز که در آن مدل دانستههای قبلی خود را از دست میدهد، میتوان از روشهایی مانند Elastic Weight Consolidation یا مخلوط کردن داده عمومی با داده تخصصی استفاده کرد.

ابزارها و پیکربندی پیشنهادی

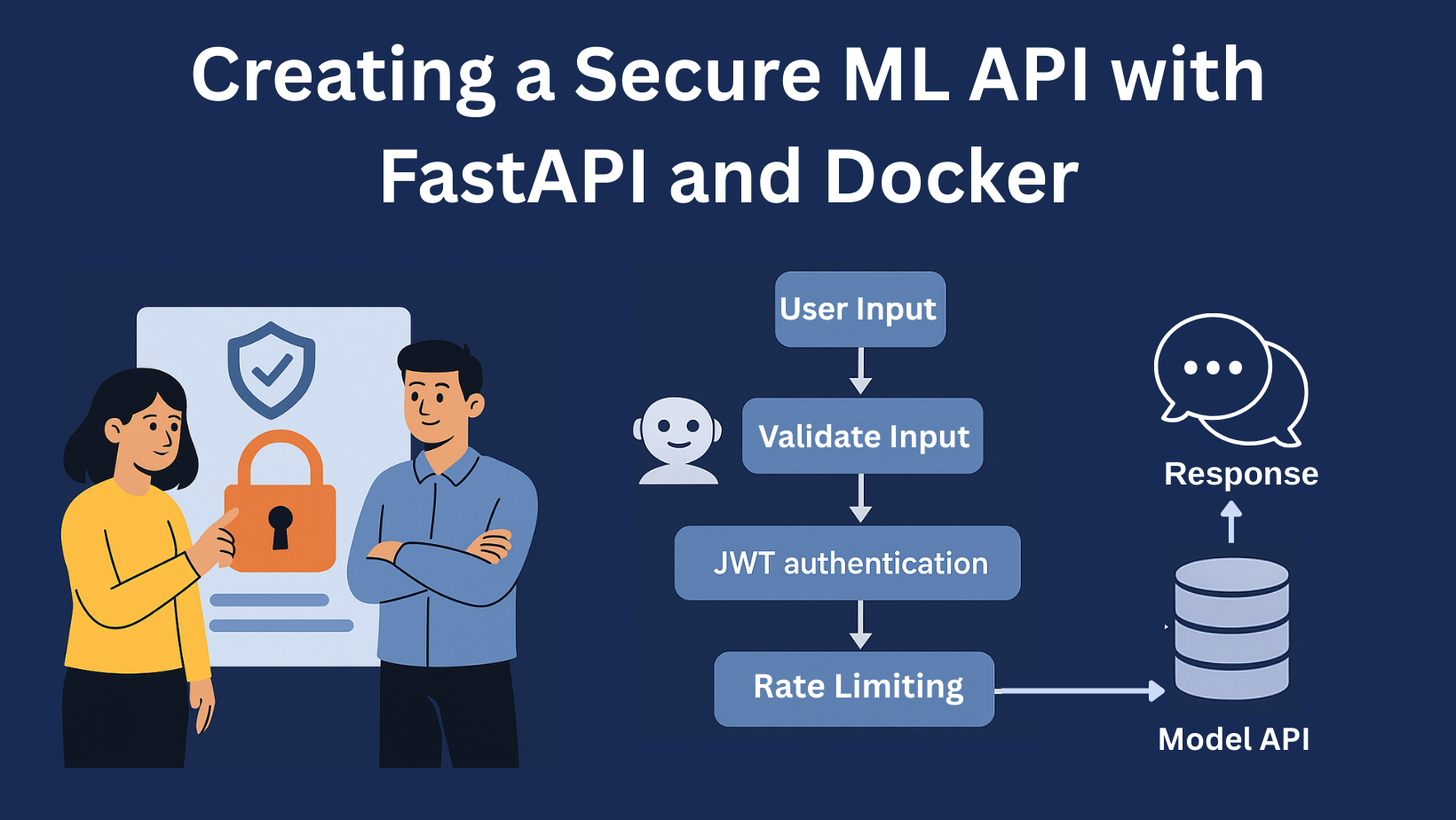

در سال 2025، اکوسیستم Hugging Face مرکز اصلی فاینتیون است. کتابخانه Transformers برای دسترسی به مدلها، PEFT برای روشهای کارآمد، و TRL برای همترازسازی استفاده میشود.

برای اجرا روی GPUهای معمولی، ابزار Unsloth بسیار محبوب است چون آموزش را تا 2 برابر سریعتر و با 80 درصد حافظه کمتر انجام میدهد.

پیکربندی پیشنهادی برای مدلهای 8 میلیارد پارامتری:

- مدل پایه: Llama 3.1-8B یا Phi-3-mini

- روش: QLoRA با فشردهسازی 4 بیت

- طول توکن: 512 تا 1024

- نرخ یادگیری: 2e-4

- اندازه دسته: 4 تا 8

- فعالسازی Gradient Checkpointing برای صرفهجویی در حافظه

مسیر یادگیری گام به گام

- با Instruction Tuning شروع کنید.

- پس از تسلط، سراغ DPO بروید تا ترجیحات انسانی را بیاموزید.

- از مدلهای کوچکتر (1 تا 3 میلیارد پارامتر) برای تمرین استفاده کنید.

- عملکرد را با معیارهایی مثل BLEU، Rouge یا G-Eval ارزیابی کنید.

- در نهایت، پس از اطمینان از پایداری، مدل را روی دادههای واقعی مقیاس دهید.

جمع بندی

فاینتیون مدلهای زبانی در سال 2025 دیگر یک فرآیند پیچیده یا گران نیست. با روشهای پارامتری کارآمد مانند LoRA و QLoRA، حتی کاربران با GPUهای مصرفی میتوانند مدلهایی در سطح صنعتی بسازند. موفقیت در این مسیر بیش از هر چیز به کیفیت داده، تصمیمگیری درست در انتخاب روش، و پایش مداوم آموزش بستگی دارد.

کلمه کلیدی: فاینتیون مدلهای زبانی

اسلاگ: fine-tuning-language-models-2025

توضیحات متا: راهنمای کامل فاینتیون مدلهای زبانی در سال 2025 با معرفی روشهای LoRA، QLoRA و Spectrum برای آموزش مدلهای بزرگ با حداقل منابع و حداکثر کارایی.